Что такое robots.txt и для чего он нужен?

Robots.txt — это текстовый файл, который содержит параметры индексирования сайта для роботов поисковых систем (информация Яндекса).В основном он нужен чтобы закрыть от индексации страницы и файлы, которые поисковикам индексировать и, следовательно, добавлять в поисковую выдачу не нужно.

Обычно это технические файлы и страницы, панели администрирования, кабинеты пользователя и дублирующаяся информация, например поиск вашего сайта и др.

Создание базового robots.txt для Битрикс

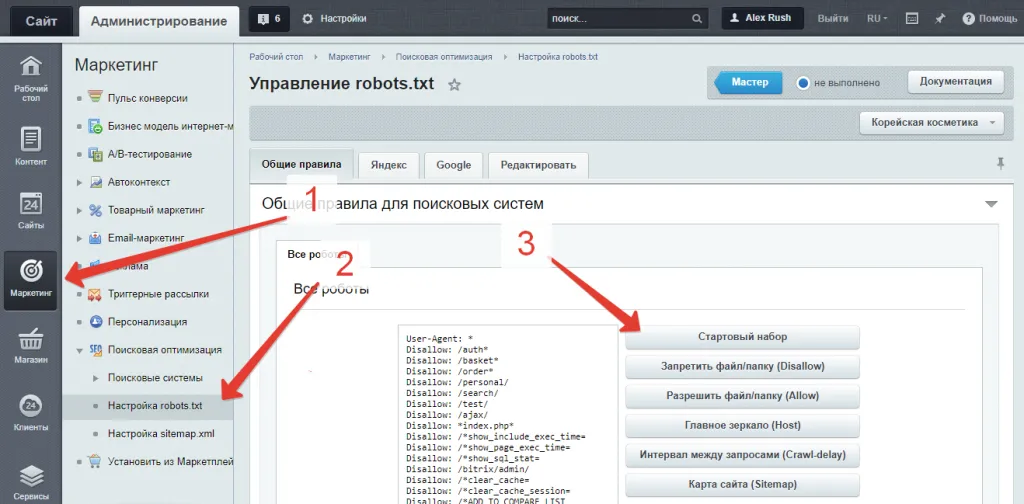

Частая ошибка начинающих кроется в ручном составлении этого файла. Это делать не нужно.В Битриксе уже есть модуль, отвечающий за файл robots.txt. Его можно найти на странице «Маркетинг -> Поисковая оптимизация -> Настройка robots.txt».

На этой странице есть кнопка для создания базового набора правил под систему Битрикс. Воспользуйтесь ей, чтобы создать все стандартные правила:

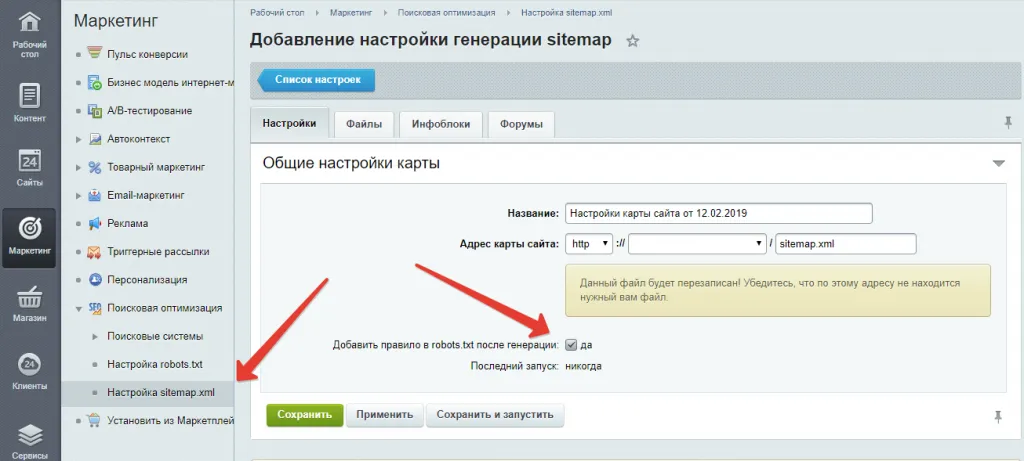

Дальше в настройках генерации карты сайта укажите галочку для добавления ее в robots.txt:

После генерации карты сайта путь к ней автоматически добавится в robots.txt.

После этого у вас уже будет хороший базовый набор правил. А дальше уже следует исходить из рекомендаций SEO-специалиста и закрывать (кнопкой «Запретить файл/папку») необходимые страницы. Обычно это страницы поиска, личные кабинеты и другие.

И не забывайте, что вы можете обратиться к нам за продвижением сайта. Мы настроим все правильно и выведем ваш сайт на Битриксе на хорошие позиции.